Трансфер

Трансфер

(от англ. to transfer — переносить, перемещать, лат. trānferre) —

термин, часто используется вместо понятия «перенос».

Tрансфер технологий

(technology transfer) - успешное применение и/или адаптация

технологии, знаний или результатов научных исследований,

полученных в одной сфере деятельности, для нужд другой (других)

сфер деятельности.

Образовательный трансфер технологий

- успешное применение и/или адаптация технологии, знаний или

результатов научных исследований, полученных в любой сфере

деятельности, для нужд образовательной деятельности.

Трансфер образовательных технологий

- процесс передачи, распространения технологий в образовательной

среде, позволяющее приобретать необходимые компетенции в организации

и реализации образовательного процесса.

Трансфер МАОТ в современные

образовательные среды - значимый фактор моделирования эффективных

образовательных систем.

Современные образовательные среды

могут быть поняты как тексты (машины), состоящие из собраний текстов

(машин)...

|

Knowledge

́ние — обладание информацией,

позволяющей решить задачу.

Знание противоположно незнанию (отсутствию информации).

Знание объективируется, фиксируется, выражается в знаковой форме

(например, в языке).

Знание (в теории ИИ) — это совокупность данных о свойствах объектов

и процессов, а также правил логического вывода одних утверждений из

других и правил использования их для принятия решений.

Главное отличие знаний от данных состоит в их структурности и

активности: появление в базе знаний новых фактов или установление

новых связей между ними может стать источником изменений в принятии

решений.

Сложные системы искусственного интеллекта, основанные на

нейросетевой технологии, а также экспертные системы, основанные на

логической модели баз знаний, демонстрируют поведение, которое

имитирует человеческое мышление и интуицию.

Обучение таких систем — эвристический процесс, состоящий в

нахождении решения задачи на основе ориентиров поиска, недостаточных

для получения логического вывода.

Графовые технологии – это основа для создания интеллектуальных

приложений. Граф знаний – одна из основных областей ИИ, который

позволяет понимать предписывающую аналитику и приложения ИИ.

Совместное применение графовых технологий, методов и алгоритмов

машинного обучения позволяет получать скрытые зависимости и

выполнять предиктивный анализ информации, получать ответы в режиме

реального времени, реализовывать алгоритмы искусственного

интеллекта.

База знаний (БЗ; англ. knowledge base, KB) — база данных, содержащая

правила вывода и информацию о человеческом опыте и знаниях в

некоторой предметной области (ISO/IEC/IEEE 24765-2010[1], ISO/IEC

2382-1:1993[2]). В самообучающихся системах база знаний также

содержит информацию, являющуюся результатом решения предыдущих

задач[1].

Современные базы знаний работают совместно с системами поиска и

извлечения информации. Для этого требуется некоторая модель

классификации понятий и определённый формат представления знаний.

Иерархический способ представления в базе знаний набора понятий и их

отношений называется онтологией.

Онтологию некоторой области знаний вместе со сведениями о свойствах

конкретных объектов часто называют «базой знаний». Вместе с тем

полноценные базы знаний[3] (в отличие от обычной базы данных)

содержат в себе не только фактическую информацию, но и правила

вывода, позволяющие делать автоматические умозаключения об уже

имеющихся или вновь вводимых фактах и тем самым производить

семантическую (осмысленную) обработку информации.

Область наук об искусственном интеллекте, изучающая базы знаний и

методы работы со знаниями, называется инженерией знаний.

Граф знаний (Knowledge graph) - это база знаний , которая использует

графическая модель данных или топология для интеграции данных.

Графы знаний часто используются для хранения взаимосвязанных

описаний сущностей - объектов, событий, ситуаций или абстрактных

концепций - с семантикой произвольной формы.

С момента развития семантической сети , графы знаний широко

используются в поисковых системах (Google , Bing); службах ответов

на вопросы (WolframAlpha , Apple Siri и Amazon Alexa ; и социальные

сети, такие как LinkedIn и Facebook .

Этот термин был придуман еще в 1972 году при обсуждении того, как

создавать модульные системы обучения для курсов.

Различия между семантическими сетями и графами знаний размыты.

Инженерия знаний (англ. knowledge engineering) — входит в область

наук об искусственном интеллекте, связана с разработкой экспертных

систем и баз знаний. Относится ко всем техническим, научным и

социальным аспектам, связанным с построением, поддержкой и

применением систем, использующих знания. Изучает методы и средства

извлечения, представления, структурирования и использования знаний

до программной реализации компонентов системы[1]. Инженерия знаний

применяется в менеджменте знаний для организации сбора, накопления,

хранения и использования знаний организации в стратегии управления

знаниями, ориентированную на кодификацию знаний.[2][3]

|

Transfer Learning

Transfer Learning: как

быстро обучить нейросеть на своих данных

https://habr.com/ru/company/binarydistrict/blog/428255/

Deep Learning: Transfer learning и тонкая настройка глубоких

сверточных нейронных сетей

https://habr.com/ru/company/microsoft/blog/314934/

Автор оригинала: Anusua Trivedi

Transfer

Learning (трансферное обучение) —

раздел машинного обучения, основанный на переносе моделей решения

одних задач на другие.

Например,

модели, полученные при обучении классификации статей Википедии,

можно использовать для:

-

медицинской диагностики,

-

классификации автомобилей,

-

распознавании птиц в небе,

-

идентификации голоса

В 1993 году

статья

Lorien Pratt

«Discriminability-Based Transfer between Neural Networks» (Передача

между нейронными сетями на основе различимости)

представила миру

потенциал трансферного обучения.

Сегодня Transfer

Learning является мощным инструментом искусственного интеллекта.

Transfer

Learning

предполагает:

-

Наличие

открытой предварительно обученной модели (модели,

созданной и обученной

на большом наборе данных (Big

Data) с использованием больших вычислительные ресурсы,

затрат и времени)

-

Переназначение готовой модели на решение другой задачи с

помощью выделения признаков (Feature extraction) или

дообучения (Fine Tuning)

Предварительно

обученные сети используются для дообучения (fine-tuning) или

выделения признаков (feature extraction).

Погружение в свёрточные нейронные

сети: передача обучения (transfer learning)

https://habr.com/ru/post/467967/

Transfer learning — это применение к решению задачи знаний,

извлеченных нейронной сетью при решении другой задачи.

Глубокие нейронные сети требуют больших объемов данных для

сходимости обучения. Поэтому часто встречается ситуация, когда для

решаемой задачи недостаточно данных для того, чтобы хорошо

натренировать все слои нейросети. Для решения этой проблемы и

используется transfer learning[22].

Чаще всего transfer learning выглядит следующим образом: к

натренированной на определенную задачу нейросети добавляется еще

несколько скрытый слоев, которые позволяют использовать уже

полученные знания для решения более конкретной задачи. Например,

знания, полученные при обучении распознаванию различных предметов,

могут применяться при решении задачи распознавания еды.

|

Fine Tuning

Fine Tuning -

дообучение

Для

Fine Tuning

используются представления, полученные предыдущей моделью, для

извлечения признаков из новых образцов, которые затем пропускаются

через новый классификатор. В этом методе просто добавляется

классификатор, который будет обучаться с нуля, поверх предварительно

обученной модели для решения целевой функции.

В сверточные архитектуры нейронных сетей (CNN) обычно состоят из

двух частей: сверточной и полносвязной. Для выделения признаков (feature

extraction) сверточная часть остаётся неизменной. В то время как

Fine Tuning захватывает несколько последних сверточных слоев.

Сверточная основа не используется по причине их универсальности.

Так, например, они имеют представления о присутствии объектов и их

местоположении. С другой стороны, полносвязные слои не имеют знаний

о местоположении объектов, т.е. не обладают свойством

инвариантности, поэтому их безбоязненно можно поменять на

собственные.

Выделение признаков в Transfer Learning реализуется двумя способами:

Новые данные пропускаются через сверточную основу, т.е. делается

предсказание модели (predict). Результат предсказаний записывается,

а затем пропускается через созданный полносвязный слой

Имеющаяся модель дополняется полносвязными слоями. Сверточную основу

замораживают, чтобы при обучении её коэффициенты не изменялись.

Данный способ позволяет использовать расширение данных (Data

Augmentation), поэтому можно заранее подготовить и увеличить

исходный датасет. Этот способ затратнее первого

ЧТО ВЫБРАТЬ ДООБУЧЕНИЕ ИЛИ ВЫДЕЛЕНИЕ ПРИЗНАКОВ

Оба метода могут повысить точность модели, но при условии наличия

достаточного объёма данных, в противном случае сеть не «почувствует»

изменений от нового набора данных и не сможет перепрофилироваться.

Выделение признаков применяется в том случае, когда решаемая задача

прошлой сети схожа с целевой. А вот если есть существенные отличия,

то используется дообучение, которое является более затратной с

вычислительной точки зрения.еносить, перемещать, лат. trānferre) —

термин, часто используется вместо понятия «перенос».

Fine-tuning (точная настройка) -

обычно заключается (практически) в замене одного последнего слоя

модели, которая обучается (оптимизируется, корректируется) для той

же задачи, чтобы соответствовать определенным наблюдениям.

В предыдущей статье мы говорили об одном из методов Transfer

Learning — выделении признаков. Сегодня продолжим разговор о

трансферном обучении и затронем ещё один метод использования

предварительно обученных архитектур — Fine Tuning (дообучение).

Читайте далее, как замораживать и размораживать блоки

моделей TensorFlow, а также как повысить точность модели,

дообучив последние слои для решения задачи распознавания

образов.

Fine Tuning что это

В отличие от feature extraction, суть дообучения

(Fine Tuning) заключается в размораживании последних слоев

нейронной сети (Neural Net) и их обучении. Таким образом,

корректируются слои, которые имеют наиболее абстрактные

представления. Производя дообучение только нескольких слоев,

мы уменьшаем риск переобучения (overfitting). И самое

главное, это позволяет сделать текущую модель ещё более

подходящей к нашей задаче.

Если верхние слои следует дообучить, то полносвязные слои

нужно заменить на свои и тоже обучить. Процедура Fine tuning

состоит в следующем:

Заморозить все слои предварительно обученной модели.

Добавить свои слои к обученной модели. Обучить добавленные

слои. Разморозить несколько верхних слоев. Обучить эти слои

и добавленную часть вместе.

Дообучение моделей Yandex.Cloud

https://cloud.yandex.ru/docs/translate/concepts/trainings-of-models

Вы можете улучшить качество машинного перевода в определенной

области знаний, используя собственные данные для тренировки модели.

При этом качество переводов общей лексики не упадет.

Какие данные требуются для дообучения

Для дообучения требуются сегменты в виде оригинал-перевод в

ТМХ-формате.

Для получения значимого эффекта необходимы десятки тысяч таких

сегментов.

|

Feature extraction

|

Feature

extractionов выделения признаков

Для выделения

признаков используются представления, полученные предыдущей моделью,

для извлечения признаков из новых образцов, которые затем

пропускаются через новый классификатор. В этом методе просто

добавляется классификатор, который будет обучаться с нуля, поверх

предварительно обученной модели для решения целевой функции.

В сверточные архитектуры нейронных сетей (CNN) обычно состоят из

двух частей: сверточной и полносвязной. Для выделения признаков (feature

extraction) сверточная часть остаётся неизменной. В то время как

Fine Tuning захватывает несколько последних сверточных слоев.

Сверточная основа не используется по причине их универсальности.

Так, например, они имеют представления о присутствии объектов и их

местоположении. С другой стороны, полносвязные слои не имеют знаний

о местоположении объектов, т.е. не обладают свойством

инвариантности, поэтому их безбоязненно можно поменять на

собственные.

Выделение признаков в Transfer Learning реализуется двумя способами:

Новые данные пропускаются через сверточную основу, т.е. делается

предсказание модели (predict). Результат предсказаний записывается,

а затем пропускается через созданный полносвязный слой

Имеющаяся модель дополняется полносвязными слоями. Сверточную основу

замораживают, чтобы при обучении её коэффициенты не изменялись.

Данный способ позволяет использовать расширение данных (Data

Augmentation), поэтому можно заранее подготовить и увеличить

исходный датасет. Этот способ затратнее первого

ЧТО ВЫБРАТЬ ДООБУЧЕНИЕ ИЛИ ВЫДЕЛЕНИЕ ПРИЗНАКОВ

Оба метода могут повысить точность модели, но при условии наличия

достаточного объёма данных, в противном случае сеть не «почувствует»

изменений от нового набора данных и не сможет перепрофилироваться.

Выделение признаков применяется в том случае, когда решаемая задача

прошлой сети схожа с целевой. А вот если есть существенные отличия,

то используется дообучение, которое является более затратной с

вычислительной точки зрения.еносить, перемещать, лат. trānferre) —

термин, часто используется вместо понятия «перенос».

Для машинного обучения (Machine

Learning) нужны только те переменные, которые на самом деле

влияют на итоговый результат.

Выделение или отбор признаков —

это процедура отбрасывания незначащих переменных из очищенной

выборки перед запуском машинного обучения и интеллектуального

анализа данных (Data Mining).

Сокращение числа предикторов

необходимо по нескольким причинам:

· значимость признаков — как

правило, исходная выборка всегда содержит много «мусорных

данных»: шумов, выбросов, а на реальный результат влияют

лишь несколько предикторов

· точность решения — некоторые

модели Machine Learning чувствительны к величине входного

вектора. Например, у нейросетей большое число входных данных

может привести к переобучению

· скорость вычислений — чем

меньше переменных, тем быстрее будут идти расчеты.

Снижение размерности задачи —

необходимый этап подготовки данных, который оказывает решающее

значение на итоговый результат.

Снижение размерности задачи —

обязательная процедура подготовки данных к моделированию

Методы Feature Selection:

-

· методы фильтрации (filter

methods), основанные на теории вероятностей и статистических

подходах. Наиболее популярными в этой группе методов

считаются IG-индексирование (вычисление information gain),

хи-квадрат (chi-square) и mRmR, которые позволяют

ранжировать признаки по значимости, оценив степень

корреляции каждого из них с целевой переменной. Далее модель

машинного обучения использует только те предикторы, которые

соответствуют определенным критериям. Методы фильтрации

хороши тем, что они достаточно быстро работают: у них низкая

стоимость вычислений, которая зависит линейно от общего

количества предикторов. Однако, они рассматривают каждый

признак изолированно, не учитывая их взаимное влияние друг

на друга в частности и на целевую переменную вообще. Поэтому

точность моделирования с этими методами отбора признаков

недостаточно высока [2].

-

· оберточные методы (wrapper

methods) — поисковые алгоритмы, которые рассматривают

предикторы как входы, а эффективность модели как выходы,

которые должны быть оптимизированы [1]. Классификатор

запускается на разных подмножествах признаков исходной

тренировочной выборки. В этой категории есть 2 подхода:

включение (forward selection) и исключение (backwards

selection) предикторов. Методы включения начинают с пустого

подмножества, куда постепенно добавляются разные признаки. В

случае исключения метод стартует с исходного множества

признаков, постепенно удаляя из него переменные и

пересчитывая классификатор. Далее выбирается подмножество

признаков с наилучшими параметрами на обучающей выборке и

тестируется на контрольном (тестовом) датасете [2]. Есть

много способов перебора предикторов: рекурсивное удаление и

добавление, генетические алгоритмы, имитация отжига и т.д.

[1]. Оберточные методы отслеживают взаимосвязи между

признаками, однако они требуют большего количества времени,

чем фильтрация. А в случае большого количества признаков и

небольшого размера тренировочного сета существует опасность

переобучения [2].

-

· встроенные методы (embedded

methods), которые не разделяют отбор признаков и обучение

классификатора, а выделяют предикторы во время процесса

расчета модели. Эти алгоритмы требуют меньше вычислений, чем

оберточные методы, но больше, чем фильтрация. Основным

методом этой категории является регуляризация [2] —

добавление дополнительных ограничений (штрафов) к условиям

задачи, чтобы построить алгоритм, минимизирующий ошибку и

количество используемых переменных. При этом выделяют 2

подхода: L1 (лассо, lasso regression, регуляризация через

манхэттенское расстояние) и L2 (регуляризация Тихонова или

ридж-регрессия, ridge regression) [3]. Регуляризация

позволяет выявить взаимовлияние переменных, но занимает

больше времени, чем методы фильтрации [2].

Анализ взаимовлияния предикторов —

важная задача Feature Selection

|

Признаки и параметры

|

Признаки (в машинном

обучении) -

данные, которые используются как

входные сигналы для

прогнозирующей модели.

https://ru.wikipedia.org/wiki/Признак_(обучение_машин)

Признак —

индивидуальное измеримое

свойство или характеристика

наблюдаемого явления.

Выбор

информативных, отличительных и

независимых признаков критически

важен для

эффективных алгоритмов.

Признаки

обычно являются числовыми (строки и графы используются в

синтаксическом распознавании

образов).

Множество числовых признаков

удобно описать вектором

признаков. Пример достижения

классификации по двум признакам

из вектора признаков (связанных

с перцептроном) состоит из

вычисления скалярного

произведения вектора признаков и

вектора весов, сравнения

результата с пороговым значением

и решения, к какому классу

принадлежит объект на основе

этого сравнения.

https://ru.wikipedia.org/wiki/Выделение_признаков

Выделение признаков — это

разновидность абстрагирования,

процесс снижения размерности, в

котором исходный набор исходных

переменных сокращается до более

управляемых групп (признаков)

для дальнейшей обработки,

оставаясь при этом достаточным

набором для точного и полного

описания исходного набора

данных[1]. Выделение признаков

используется в машинном

обучении, распознавании образов

и при обработке изображений.

Выделение признаков начинает с

исходного набора данных, выводит

вторичные значения (признаки),

для которых предполагается, что

они должны быть информативными и

не быть избыточными, что

способствует последующему

процессу обучения машины и

обобщению шагов, а в некоторых

случаях ведёт и к лучшей

человеческой интерпретацией

данных.

Парметры относятся к алгоримам

(а не к объектам, явлениям)

Параметр модели - это переменная

конфигурации, которая является

внутренней по отношению к модели

и значение которой можно оценить

на основе данных.

Они требуются моделью при

прогнозировании.

Эти значения определяют умение

модели по вашей проблеме.

Они оцениваются или извлекаются

из данных.

Они часто не устанавливаются

вручную практикующим врачом.

Они часто сохраняются как часть

изученной модели.

Параметры являются ключевыми для

алгоритмов машинного обучения.

Они являются частью модели,

которая извлекается из

исторических данных обучения.

В классической литературе по

машинному обучению мы можем

рассматривать модель как

гипотезу, а параметры - как

адаптацию гипотезы к конкретному

набору данных.

Часто параметры модели

оцениваются с использованием

алгоритма оптимизации, который

является типом эффективного

поиска по возможным значениям

параметров.

Статистика: В статистике вы

можете принять распределение для

переменной, такое как

распределение Гаусса. Два

параметра гауссовского

распределения являются средними

(му) и стандартное отклонение

(сигма). Это относится к

машинному обучению, где эти

параметры могут быть оценены на

основе данных и использованы как

часть прогнозирующей модели.

программирование: В

программировании вы можете

передать параметр в функцию. В

этом случае параметр - это

аргумент функции, который может

иметь одно из значений. В

машинном обучении конкретная

модель, которую вы используете,

является функцией и требует

параметров для прогнозирования

новых данных.

Имеет ли модель фиксированное

или переменное число параметров,

определяет, можно ли ее назвать

«параметрический" или же

"непараметрический«.

Некоторые примеры параметров

модели включают в себя:

Веса в искусственной нейронной

сети.

Опорные векторы в машине опорных

векторов.

Коэффициенты в линейной

регрессии или логистической

регрессии.

Параметры модели — параметры,

которые изменяются и

оптимизируются в процессе

обучения модели и итоговые

значения этих параметров

являются результатом обучения

модели.

Примерами параметров могут

служить веса ребер нейронной

сети, ошибка на выходе сети,

расстояние между объектами в

кластеризации, значения

дискриминационных порогов в

классификации и т.д.

Гиперпараметры модели —

параметры, значения которых

задается до начала обучения

модели и не изменяется в

процессе обучения. В этом смысле

они и отличаются от обычных

параметров, вычисляемых в

процессе обучения.

Гиперпараметры используются для

управления процессом обучения. У

модели может не быть

гиперпараметров.

Примерами гиперпараметров могут

служить количество слоев

нейронной сети, а также

количество нейронов на каждом

слое.

|

Стили живописи = языки

|

Перенос стиля

https://habr.com/ru/post/453512/

Изображение (растровое, векторное, фрактальное) в компьютере

кодируется как последовательность символов (текст):

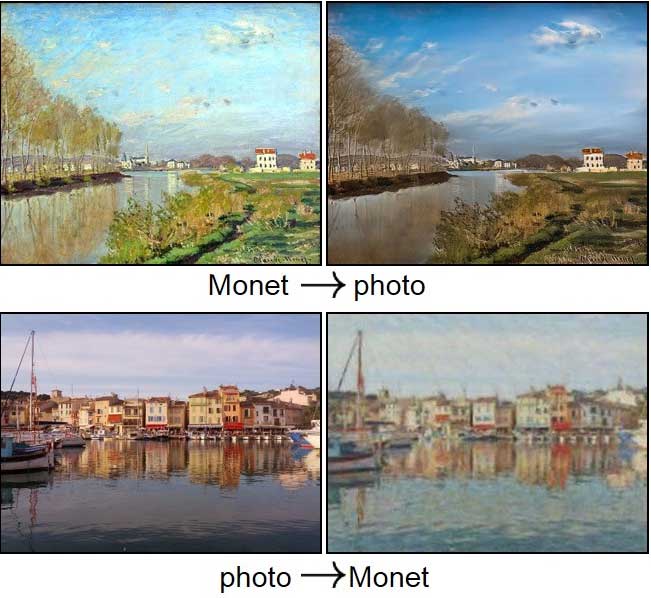

11.06.201 6Prisma — мобильное приложение (2016) Алексея Моисеенкова, позволяет (с помощью самообучающейся нейронной сети, расположенной на сервере) преобразовывать изображения в стиле работ известных художников. 20.04.2017 Программисты из Исследовательской лаборатории Калифорнийского университета в Беркли (BAIR) научили нейросеть переводить (пробразовывать) картины художников в реалистичные фотографии

Cтатья c результатами исследования здесь (PDF) Алгоритм подобен тому, который создали разработчики приложения Prisma, которое переносит стили известных художников на фотографии.

Исследователи использовали генеративную состязательную нейросеть (GAN), состоящую из двух компонентов: генератора, который создаёт синтетическое изображение, и дискриминатора, который проверяет сходство с исходником. В неё загрузили более тысячи картин Моне, Ван Гога и Сезанна, десятки тысяч фотографий с Flickr. Этот же метод позволил превращать летние пейзажи в зимние...

Стилизатор Ашманова

(стилизация изображения с помощью технологии Style Transfer - пример

использования нейросетей для дизайна).

02.04.2020

ARTS AND CULTURE.

Transform your photo in the style of an iconic artist

-

Новая функция основана на использовании нейросети, которая

заново воссоздаёт изображение на основе выбранного художественного

стиля (а

не накладывает эффекты на фото)

-

Обработка

фото происходит непосредственно на устройстве (!)

-

Открываем

меню «Камера» в нижней панели приложения Arts & Culture и выбираем

Art Transfer

-

После съёмки (выбора) фото можно выбрать шедевр, стиль которого

будет применен к фотографии

-

Можно

сделать «кроп», выбрав, к какому участку изображения он хочет

применить эффект

-

Функция «Поделиться» позволяет показать в соцсетях результаты под

хэштегом #ArtTransfer

20.01.2021

Учёные МТИ, Гарварда и Кембриджа

предложили анализировать

мутации вирусов с помощью ИИ для распознавания текста

Трансфер художественного стиля может быть

понят как межъязыковой перевод текста

Межъязыковой

перевод текста может быть понят как трансфер (перенос) стиля

Возможен (и был эффективно

реализован) трансфер технологий переноса стиля на сферу компьютерного

перевода текста. |

Белки =

тексты

Жизнь - способ существования белковых тел (Ф. Энгельс)

Белки — строительный материал клеток, ферменты-катализаторы всех

биохимических реакций.

Белки — цепочки из

аминокислот.

Белки (протеины, полипептиды)

— высокомолекулярные органические вещества, состоящие из

аминокислот , соединённых в цепочки (пептидной связью).

В живых организмах

аминокислотный состав белков определяется генетическим

кодом.

Множество комбинаций 20

стандартных аминокислот создают молекулы белков с большим

разнообразием свойств.

Пептиды (греч. питательный) —

органические вещества, построенные из остатков аминокислот,

соединённых в цепь пептидными (амидными) связями.

Число аминокислот в цепочках

пептидов варьируется от двух (дипептид) до 50.

Белки обычно называют полипептиды,

содержащие от 50 до десятков тысяч аминокислотных остатков.

Аминокислоты — органические

соединения,

включающие углерод (C), водород (H), кислород (O) и азот (N).

Известны около 500 различных

аминокислот. В генетическом коде используется 20 различных

аминокислот.

C, H, O, N - алфавит.

Аминокислоты - слова (токены, граммы, термы)

Пептиды - короткие тексты

(предложения +)

Белки - большие тексты

Жизнь - способ существования текстов

|

Белки =

молекулярные машины

Молекулярная

машина

https://ru.wikipedia.org/wiki/Молекулярная_машина

Биологические молекулярные машины

Самые сложные макромолекулярные механизмы находятся внутри

клеток, часто в форме мультибелковых комплексов

Молекулярные

машины: что это такое и как их делать?

https://polit.ru/article/2014/02/17/avetisov/

-

Клетку можно называть

операциональной системой, построенной из молекулярных машин

(белков) и производящей молекулярные машины (белки).

-

Почему язык кибернетики так

хорошо ложится на генетику?

Программа, считывание информации - почему?

Именно потому, что процессы, которые протекают в клетке,

очень похожи на вычисления.

Д.С. Чернавский, Н.М. Чернавская

«БЕЛОК-МАШИНА» М.:

Янус-К, 1999, 256с. Д.С. Чернавский, Н.М. Чернавская

«БЕЛОК-МАШИНА» М.:

Янус-К, 1999, 256с.

Монография посвящена фундаментальным

проблемам строения и функционирования белков-ферментов. Стержень

книги - аналогия между белками-ферментами и макроскопическими

конструкциями.

Природные молекулярные машины – белки.

Виды:

- Цитоскелетные моторные белки

(миозин, кинезин, динеин)

- Полимеризационные моторы (актин, микротрубочки, протеин RecA)

- Ионные помпы (Na-K насос и др.)

- Роторные моторы (АТФ-синтаза, бактериальный флагеллярный

мотор)

- ДНК моторы (РНК-полимеразы, геликазы)

Функции:

- Сокращение волокон и мышц

(актин-миозин)

- Движение клетки (актин-миозин)

- Деление клетки (актин-миозин)

- Разделение хромосом (микротрубочки, динеин)

- Транспорт (микротрубочки, кинезин/динеин)

- Бактериальный хемотаксис (флагеллярный мотор)

- Хранение энергии в АТФ (АТФ-синтаза)

Концепция «белок – машина» претерпела

существенные изменения.

В настоящее время «молекулярная машина»

- ансамбль молекул, объединенных пространственно для

выполнения определенной функции.

Просто:

1) белки =

тексты

2) белки =

молекулярные машины

3)

молекулярные машины = тексты

Вывод: Предмет

МАОТ гораздо шире традиционно понимаемого текста в его устной и

письменной формах ))

|

Фолдинг белков

Функции белков определяются их

структурой

Структура =

синтаксис (грамматика)

Фолдинг

(folding, укладка) -

спонтанное сворачивания полипептидной цепи в уникальную

пространственную структуру.

В Нобелевской речи (премия по химии

1972 года) Кристиан Анфинсен предположил, что аминокислотной

последовательностью белка должна полностью определяться его

трехмерная структура и никакой дополнительной информации для

сворачивания белка не требуется.

Белок может свернуться множеством

способов.

Структурные

(синтаксические) уровни:

-

Последовательность аминокислот (их свойств и взаимодействия) -

первичный уровень структурной иерархии белка.

-

Вторичную структуру определяют водородные связи между аминокислотами

близкого действия.

-

Третичную структуру формируют комбинации первых двух на основе

дальнодействующих связей (гидрофобность ++).

Нейросеть AlphaFold 2 от компании DeepMind

успешно предсказывает

(моделирует, конструирует) трехмерные структуры белка по его

аминокислотной последовательности.

Успех достигнут после 49 лет экспериментов с помощью компьютера.

Систему обучили на 170 000 структур белков из банка данных белков

вместе с большими базами данных, содержащими последовательности

белков неизвестной структуры.

|

DeepMind

-

в 2010 основана Демисом Хассабисом, Мустафой Сулейманом

и Шейном Леггом, инженерами ИИ и пионерами глубокого

обучения,

-

приобретена в

2015 Google за $500 000 000+

(75 человек)

-

до 2020 года компания была убыточной, в

2019 году убыток достиг $649 000 000.

-

в 2021 DeepMind впервые отчиталась о

прибыли $59,6 миллиона (прибыль связывают с «креативным

бухгалтерским учетом», поскольку доход

компании зависит от оплаты Alphabet

внутренних услуг).

-

DeepMind

годами вела

переговоры с Google об автономии под

управлением некоммерческих

организаций: возможности ИИ не

должны контролироваться одной

корпорацией. В конце апреля 2021 Google

окончательно отказала в автономии.

-

Alphabet Inc.

заявила, что инвестирует миллиарды

долларов в развитие

DeepMind.

План по удвоению штата

команды, которая изучает этику

применения AI.

-

в 2021 в DeepMind 1000+

человек, а средняя годовая зарплата $ 1

000 000+.

-

Исследовательские

центры в США, Канаде и Франции.

-

ИИ на уровне

человека может быть достигнут тогда,

когда программа может играть в разные

игры.

в 2016 создан AlphaGo, который победил чемпион

мира по го Ли Седоля.

AlphaZero,

которая играет в шахматы и сёги. Системы, которые могут играть в самые

разные игры.

-

Алгоритмы обучения DeepMind общего

назначения позволяют машине учиться

посредством геймификации, чтобы

попытаться приобрести человеческий

интеллект и поведение.

-

В центре внимания

безопасность использования ИИ. Разработан тестовый проект GridWorld

с открытым исходным кодом, чтобы

определить, есть ли в алгоритме

переключатель уничтожения при

нежелательном поведении. Проект гарантирует,

что ИИ остается безопасным и безвредным

для себя, разработчиков и других людей,

подвергающихся его воздействию.

-

DeepMind поднял глубокое обучение на

совершенно другой уровень, внедрив

революционную технологическую систему.

Эта система называется обучением с

глубоким подкреплением, которое

независимо от обычных систем

ИИ.

Например, IBM Watson или Deep Blue был

разработан с определенной целью и

запрограммирован на работу только в

желаемой плоскости.

Обучение глубокому подкреплению DeepMind

не запрограммировано заранее, а учится с

опытом, как любой человек. По сути, оно

основывается на сверточной нейронной

сети и соединяет ее с Q-обучением. Их

системы затем тестируются на различных

видеоиграх без запрограммированных

инструкций.

Система делает все независимо, она

учится играть в видеоигры и, после

нескольких попыток, играет лучше, чем

любой человек. Обучение с глубоким

подкреплением устраняет любые

человеческие ошибки, которые могут

повлиять на эффективность игрового

процесса.

-

WaveNet Collaboration

Сотрудничество с WaveNet стало одним из

самых значительных достижений в области

здравоохранения, которому способствовал

DeepMind. Есть миллионы людей, которые

страдают от нарушения речи и не могут

вернуть свой первоначальный голос.

Системы преобразования текста в речь

часто производят роботизированные или

неестественно звучащие голоса. DeepMind

сотрудничал с Google и людьми с

нарушениями речи.

Цель заключалась в разработке системы,

которая звучит как естественный голос

пациента, что может сначала показаться

невыполнимой миссией. Воссоздание голоса

требует нескольких часов аудиозаписей

этого человека, читающего определенный

сценарий.

К сожалению, люди с нарушениями речи

могут не иметь такой роскоши. DeepMind

разработал алгоритм, который требует

лишь несколько аудиозаписей для

воссоздания голоса.

-

Система AI

DeepMind собирает данные о ваших

предпочтениях, а затем рекомендует

приложения, аналогичные тем, которые вы

загружали ранее.

-

Системы DeepMind повысили эффективность

систем охлаждения серверов Google в

центрах обработки данных. Очень скоро у

пользователей устройств на Android Pie

появятся такие функции, как

адаптивная яркость и заряд батареи.

Машинное обучение поможет с

энергосбережением на этих

устройствах, адаптируя яркость к

текущим условиям освещения.

-

DeepMind совместно с ведущими учеными

применила искусственный интеллект для

решения сложных математических задач и

доказательства теорем.

Они разработали алгоритм, который

позволяет исследователям быстро

формулировать различные гипотезы и

проверять их на практике, а также искать

различные неочевидные закономерности.

В ходе исследований модели помогли

австралийскому профессору Джорди

Уильямсону и его коллегам найти решение

и доказательство для двух гипотез в

области теории узлов и теории

представлений. В частности, они открыли новый подход

к связанной с многочленами Каждана-Люстига гипотезе, выдвинутой 40

лет назад. Это, по словам специалистов

DeepMind, говорит о возможностях

широкого применения ИИ во всех сферах

науки.

|

Демис Хассабис

Демис Хассабис

(англ. Demis Hassabis; родился 27 июля 1976 года) — британский

исследователь искусственного интеллекта, нейробиолог, разработчик

компьютерных игр, игрок мирового класса в шахматы. Член Королевской

инженерной академии Великобритании (2017), Лондонского королевского

общества (2018)[2]. Лауреат премии Дэна Дэвида (2020).

|

Три великие

истины про ИИ

https://sergey-57776.medium.com/три-великие-истины-про-ии-92ccd460b1ae

Демис Хассабис только что изложил свое видение будущего ИИ и

сформулировал “три истины”

1) ИИ может спасти человечество от самих себя, и в

первую очередь, в сфере геополитики.

2) Компенсировав худшие последствия человеческой

жадности и эгоизма, ИИ совершит переворот в науке,

генерируя серии открытий Нобелевского уровня.

3) Глубокого обучения недостаточно для решения

проблемы общего ИИ. Следуя сегодняшнему мейнстриму

ИИ исследований и разработок, эту проблему

невозможно решить. Нужна междисциплинарка,

мозгоподобные подходы и принципиально иные концепции

ИИ: не нынешнего Искусственного Интеллекта, а

Истинного Интеллекта.

|

Демис Хассабис —

великий интеллект, который создал великий интеллект

Автор оригинала: Tom Whipple

https://habr.com/ru/company/edison/blog/436394/

|

Источники

DeepMind

рекомендует

|